Googleの人工知能専用の一部門である「Google AI」が現在研究している手話翻訳システムが画期的だと話題になっている。

スマホのカメラで手話を捉えれば、言語翻訳が可能!?

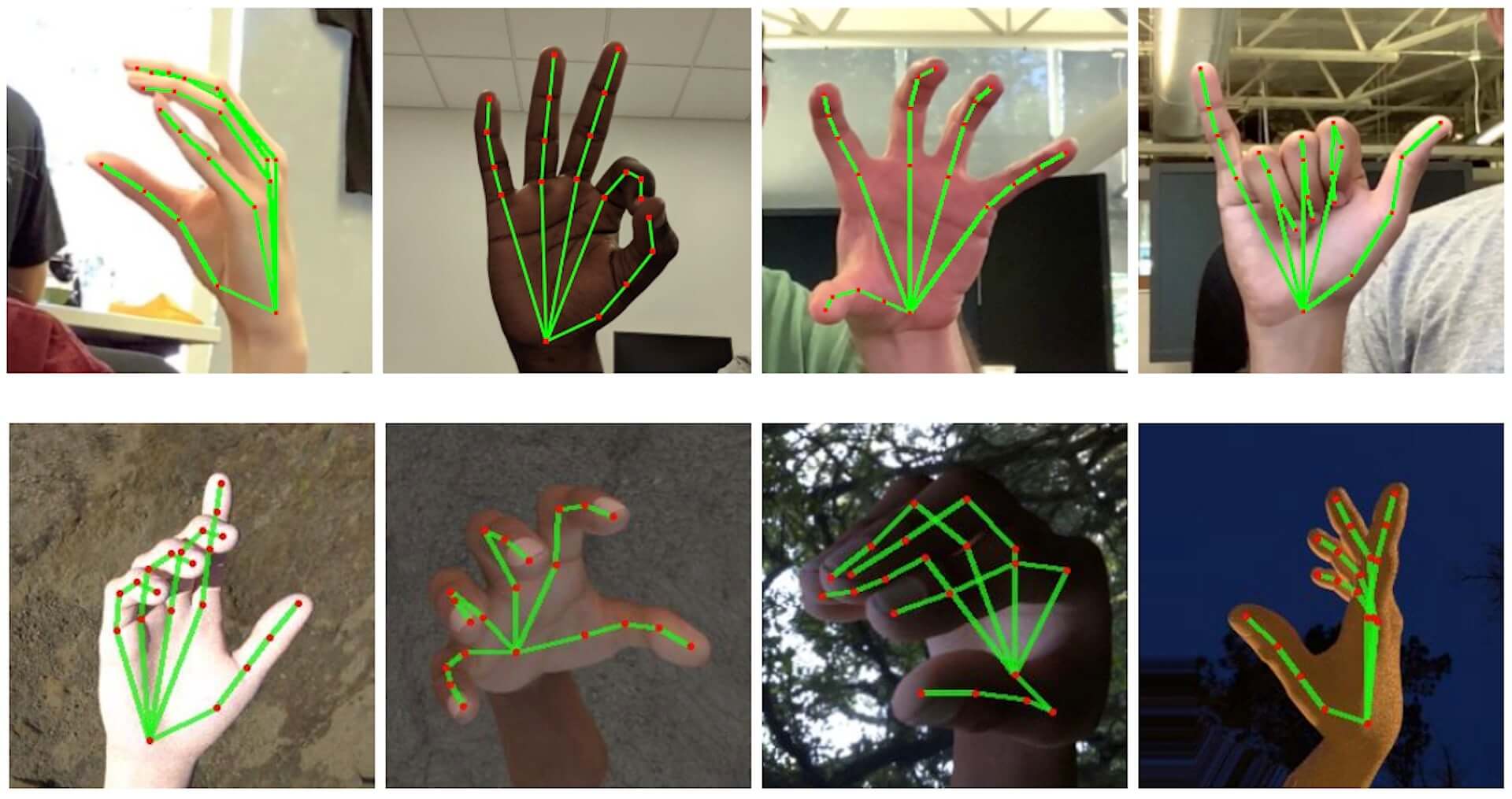

Google AIの公式ブログによれば、Googleが現在開発している手の知覚機能は今年6月にカリフォルニアで開催された<CVPR 2019>でプレビューされたもので、スマートフォンのカメラを通して手話者の手や指の動きを捉えることで、その手話の意味をかなり正確に翻訳することができる技術だ。現状、手をぐっと握ったり、開いたり、またメロイックサインやピースサインなど、指の動きが複雑なハンドサインでもその意味を理解できるようにまでこの技術が進歩しているようだ。

本ブログ内でGoogleの研究員であるValentin Bazarevsky氏とFan Zhang氏は「現在の最先端の研究が主に強力なデスクトップ環境に頼っている一方で、我々の方法では携帯電話でリアルタイムの(手の)動きを捉えることに成功し、また複数の手の形を捉えることができます」と説明している。

Google AIの研究チームはこの技術を開発する上で、「BlazePalm」と呼ばれる単発検出器を応用しており、手全体ではなく手のひらの動きを検知できるよう検出器を訓練していったところ、手を組んだり、誰かと握手をしたりとふたつ以上の手が交差する場合でも、手のひらの動きを検知できるようになったのだとか。

続いて、指の動きに対応させるために、まず30,000もの手のひらの画像から、動きの支柱となる21のポイントを学習させることで、上記のような複雑な指の動きにも対応できるのになったという。

この技術が普及されるとなると、スマートフォンさえあれば耳が聞こえない方との会話も瞬時に、スムーズにできるということになる。現状研究段階ではあるが、Googleはこの技術を応用してさらにさまざまな研究開発が進展することを望んでいる、とブログを締めくくっている。